Допустим, у вас есть фотография Хью Джекмана для рекламы. Он отлично выглядит, но клиент хочет, чтобы он выглядел немного счастливее. Нет, приглашать знаменитость на очередную фотосессию не нужно. Вам даже не нужно часами работать с Photoshop. Вы можете автоматически сгенерировать дюжину изображений из этого единственного изображения, на котором у Хью будут улыбки разной интенсивности. Вы даже можете создать анимацию из этого единственного изображения, где Хью меняет выражение своего лица с абсолютно серьезного на абсолютно счастливое.

Авторы новой схемы кондиционирования GAN, основанной на аннотациях Action Units (AU) утверждают, что такой сценарий не является футуристическим, но абсолютно реализуемым на сегодняшний день. В этой статье мы сделаем обзор их подхода, рассмотрим результаты, полученные с помощью предлагаемого метода, и сравним его эффективность с современными подходами.

Предлагаемый метод

Выражение лица - результат комбинированного и скоординированного действия мимических мышц. Их можно описать в терминах так называемых единиц действия, которые анатомически связаны с сокращениями определенных лицевых мышц. Например, выражение лица для страха обычно создается с помощью следующих активаций: средство для подъема внутренних бровей (AU1), средство для подъема наружных бровей (AU2), средство для поднятия бровей (AU4), средство для подъема верхних век (AU5), Натяжитель крышки (AU7), растяжитель губ (AU20) и выпадение челюсти (AU26). Величина каждой ЕД определяет степень эмоции.

Основываясь на этом подходе к определению мимики, Пумарола и его коллеги предлагают архитектуру GAN, которая обусловлена одномерным вектором, указывающим наличие / отсутствие и величину каждой единицы действия. Они обучают эту архитектуру неконтролируемым образом, для чего требуются только изображения с их активированными AU. Затем они разбивают проблему на два основных этапа:

- Рендеринг нового изображения в соответствии с желаемым выражением с учетом двунаправленной состязательной архитектуры, обусловленной AU, на основе одной обучающей фотографии.

- Возврат синтезированного изображения в исходную позу.

Более того, исследователи хотели убедиться, что их система сможет обрабатывать изображения при изменении фона и условий освещения. Следовательно, они добавили в свою сеть слой внимания. Он фокусирует действие сети только на тех областях изображения, которые имеют отношение к передаче нового выражения.

Теперь перейдем к следующему разделу, чтобы раскрыть детали этой сетевой архитектуры - как ей удается генерировать анатомически согласованные лицевые анимации из изображений в дикой природе?

Сетевая архитектура

Предлагаемая архитектура состоит из двух основных блоков:

- Генератор G регрессирует внимание и цветовые маски (обратите внимание, что он применяется дважды: сначала для сопоставления входного изображения, а затем для его рендеринга). Цель заключалась в том, чтобы генератор фокусировался только на тех областях, которые отвечают за синтез нового выражения лица, сохраняя при этом нетронутыми остальные элементы изображения, такие как волосы, очки, шляпы или украшения. Таким образом, вместо регрессии полного изображения этот генератор выводит цветовую маску C и маску внимания A. Маска A указывает, в какой степени каждый пиксель C вносит вклад в выходное изображение. Это приводит к получению более четких и реалистичных изображений в конце.

- Условный критик. Критик D оценивает сгенерированное изображение с точки зрения фотореализма и выражения, обусловливающего выполнение.

Функция потерь для этой сети представляет собой линейную комбинацию нескольких частичных потерь: потери изображения, потери внимания, потери условного выражения и потери идентичности:

Модель обучается на подмножестве 200 000 изображений из набора данных EmotioNet с использованием оптимизатора Adam со скоростью обучения 0,0001, beta1 0,5, beta2 0,999 и размером пакета 25.

Экспериментальная оценка

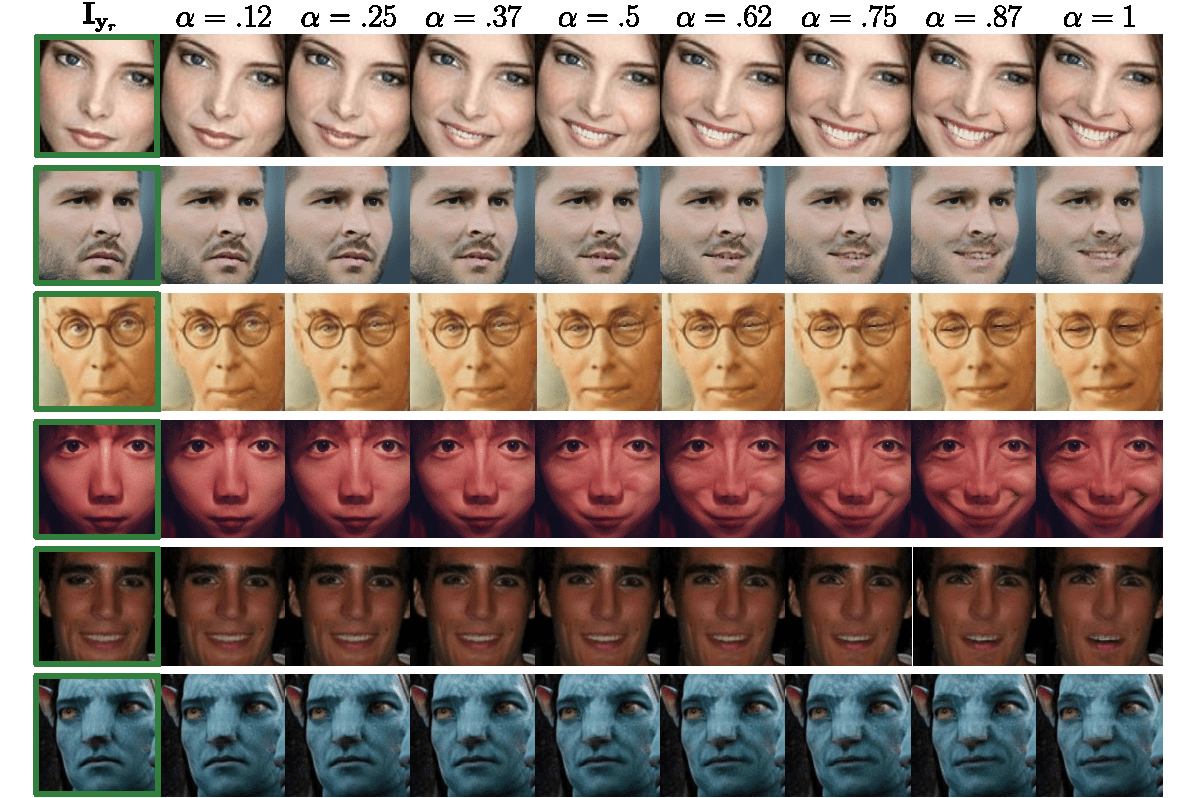

Изображение ниже демонстрирует способность модели активировать AU с разной интенсивностью, сохраняя при этом личность человека. Например, вы можете видеть, что модель правильно обрабатывает случай с нулевой интенсивностью и генерирует идентичную копию входного изображения. Для ненулевых случаев модель реалистично отображает сложные движения лица и выводит изображения, которые обычно неотличимы от реальных.

На следующем рисунке показаны маска внимания A и цветовая маска C. Вы можете увидеть, как модель неконтролируемым образом фокусирует свое внимание (более темная область) на соответствующих единицах действия. Следовательно, тщательно оцениваются только пиксели, относящиеся к изменению выражения, в то время как пиксели фона напрямую копируются из входного изображения. Эта функция модели очень удобна при работе с изображениями в дикой природе.

Теперь давайте посмотрим, как модель справляется с задачей редактирования нескольких AU. Результаты показаны ниже. Здесь вы можете наблюдать удивительно плавное и последовательное преобразование между кадрами даже при сложных условиях освещения и нереальных данных, как в случае с аватаром. Эти результаты побуждают авторов расширить свою модель до генерации видео. Им обязательно стоит попробовать, не так ли?

Между тем, они сравнивают свой подход с несколькими современными методами, чтобы увидеть, насколько хорошо их модель работает при генерации различных выражений лица из одного изображения. Результаты показаны ниже. Похоже, что нижняя строка, представляющая предлагаемый подход, содержит гораздо более привлекательные изображения с заметно более высоким пространственным разрешением. Как мы уже обсуждали ранее, использование маски внимания позволяет применить преобразование только к обрезанному лицу и вернуть его к исходному изображению, не создавая артефактов.

Ограничения модели

Давайте теперь обсудим ограничения модели - с какими типами сложных изображений она все еще может справиться, а когда действительно терпит неудачу. Как показано на изображении ниже, модель успешно работает со скульптурами, похожими на человека, нереалистичными рисунками, неоднородными текстурами на лице, антропоморфными лицами с ненастоящими текстурами, нестандартным освещением / цветами и даже с эскизами лиц. .

Однако есть несколько случаев, когда это не удается. Первый случай неудачи, изображенный ниже, является результатом ошибок в механизме внимания при задании крайних входных выражений. Модель также может выйти из строя, если входное изображение содержит невидимые ранее окклюзии, такие как повязка на глазу, вызывающая артефакты в недостающих атрибутах лица. Он также не готов иметь дело с нечеловеческими антропоморфными распределениями, как в случае с циклопами. Наконец, модель также может создавать артефакты, такие как черты человеческого лица, при работе с животными.

Нижняя линия

Представленная здесь модель способна генерировать анатомически ориентированные анимации лица из изображений в дикой природе. Полученные изображения удивляют своей реалистичностью и высоким пространственным разрешением. Предложенный подход продвигает текущие работы, в которых решалась только проблема редактирования категорий дискретных эмоций и портретных изображений. Его ключевой вклад включает а) кодирование деформаций лица с помощью AU для рендеринга широкого диапазона выражений и б) встраивание модели внимания, чтобы сосредоточиться только на соответствующих областях изображения. Несколько случаев сбоя, которые наблюдались, предположительно связаны с недостаточным количеством обучающих данных. Таким образом, мы можем сделать вывод, что результаты этого подхода очень многообещающие, и мы с нетерпением ждем возможности увидеть его эффективность для видеопоследовательностей.

Изначально опубликовано на neurohive.io.